米NVIDIAは3月18日(現地時間)、5年ぶりに開催の年次カンファレンス「GTC 2024」で、AI向けプラットフォーム「Blackwell」を発表した。“兆パラメータでリアルタイム生成AIを構築および実行できるようになる”としている。

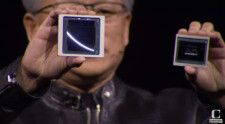

ジェンスン・ファンCEOは基調講演で、Blackwellは、ゲーム理論で知られる米国の数学者、デビッド・ブラックウェル氏(リンク先はWikipedia)にちなんだと語った。

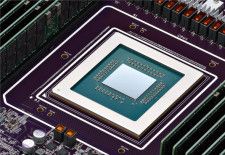

プラットフォームに搭載する「GB200 Grace Blackwell Superchip」は、新GPU「B200」(2080億個のトランジスタを搭載し、現行の「H100」と比較して、AI向けの作業で5倍の処理能力を発揮するGPU)を2基と1基のGrace CPUを組み合わせたもの。

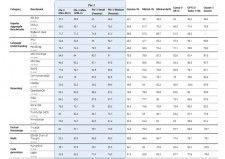

NVIDIAによると、1兆8000億パラメータのAIモデルをトレーニングするには、Hopper GPUでは8000個のGPUで15メガワットの電力が必要だったが、新スーパーチップであれば2000個で可能で、消費電力は4メガワットで済むという。

NVIDIAはGB200を、水冷ラックスケールシステム「NVL72」などで提供する。これは第5世代NVLinkで接続された72個のBlackwel GPUと36個のGrace CPUを含む36個のGrace Blackwellスーパーチップを搭載する。

Blackwellプラットフォームの製品は、今年後半からパートナーから提供される予定。Google、Meta、Microsoft、OpenAI、Oracle、Tesla、xAI、Amazon傘下のAWS、DellなどがBlackwellを採用する見込みという。

プレスリリースには、OpenAIのサム・アルトマンCEOやTeslaとxAIのCEOでもあるイーロン・マスク氏からのコメントが紹介されている。

Google Cloud、AWS、Microsoft、Oracleが今年後半にBlackwell搭載インスタンスのホストを開始する予定。

GB200は、NVIDIA DGX Cloudでも利用可能になる見込みだ。

プロバイダならOCN

プロバイダならOCN