米AI企業のDatabricksは3月27日(現地時間)、“オープンな”汎用LLM「DBRX」を発表した。同社によると、DBRXは標準的なベンチマークで既存のすべてのオープンモデルより優れたパフォーマンスを発揮するという。ただし、マルチモーダルではない。

DBRXは、オープンソースプロジェクトMegaBlocksに基づいて構築されたMoE(Mixture of Experts;混合エキスパート)を採用した。このMoEは、他のMoEと比較してトレーニング速度が2倍以上、計算効率も最大2倍になるという。

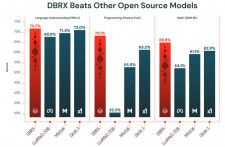

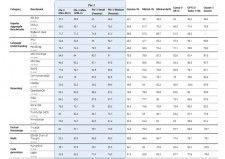

サイズは1320億パラメータと米MetaのLlama 2のほぼ2倍だが、速度はLlama 2の2倍という。言語理解、プログラミング、数学、ロジックのベンチマークで、Llama 2 70B、仏Mistral AIのMixtral 8x7B、米XのGrok-1、米OpenAIのGPT-3.5を上回っているとしている。

DBRXは、3.2TbpsのInfinibandで接続された3072基のNVIDIA H100を使用して、パブリックデータソースとライセンス供与されたデータソースで3カ月トレーニングし、品質および安全性の改善のための人間のフィードバックを収集し、モデルを手動で実験した。

基本モデルと微調整モデルをHugging Facedeから入手し、研究および商用目的で自由に利用できる。開発者は、Databricksプラットフォーム上で独自のデータに基づいたカスタムDBRXモデルを構築することもできる。

DBRXをプライベートにホスティングしたい場合は、Databricks Marketplaceからモデルをダウンロードし、Model Servingでモデルをデプロイできる。少なくとも4基のH100を搭載したPCあるいはサーバが必要だ。

あるいは、Databricksの従量課金制プランに加入して「Databricks Mosaic AI Foundation Model API」を使うことで、すぐに使い始められる。

商用利用向けに、パフォーマンス保証、ファインチューンされたモデルのサポート、追加のセキュリティとコンプライアンスを提供するプロビジョニングされたスループットオプションも提供している。

Databricksは2013年創業の米カリフォルニア州サンフランシスコに拠点を置くAI企業(日本にも支社がある)。Lakehouse、Apache Spark、Delta Lake、MLflowの開発者らによって設立された。

プロバイダならOCN

プロバイダならOCN